CEO Nvidia Klaim Chip AI Mereka Berkembang Lebih Cepat dari Hukum Moore

Berita tentang CEO Nvidia ini masuk dalam Kategori Artificial Intelligence

CEO Nvidia, Jensen Huang, menyatakan bahwa kinerja chip AI perusahaannya berkembang lebih cepat daripada Hukum Moore, yang telah menjadi pedoman bagi kemajuan teknologi selama beberapa dekade.

“Sistem kami berkembang jauh lebih cepat daripada Hukum Moore,” kata Huang dalam wawancara dengan TechCrunch pada hari Selasa, pagi setelah ia memberikan pidato utama di hadapan 10.000 orang di CES di Las Vegas.

Diciptakan oleh salah satu pendiri Intel, Gordon Moore, pada tahun 1965, Hukum Moore memprediksi bahwa jumlah transistor pada chip komputer akan kira-kira berlipat ganda setiap dua tahun, yang pada dasarnya menggandakan kinerja chip tersebut. Prediksi ini sebagian besar terbukti benar, dan menciptakan kemajuan pesat dalam kemampuan serta penurunan biaya selama beberapa dekade.

Namun, dalam beberapa tahun terakhir, Hukum Moore telah melambat. Namun, Huang mengklaim bahwa chip AI Nvidia bergerak dengan kecepatan yang dipercepat; perusahaan ini mengatakan bahwa superchip pusat data terbaru mereka lebih dari 30 kali lebih cepat dalam menjalankan beban kerja inferensi AI dibandingkan dengan generasi sebelumnya.

“Kami dapat membangun arsitektur, chip, sistem, pustaka, dan algoritme semuanya pada saat yang sama,” kata Huang. “Jika Anda melakukannya, maka Anda bisa bergerak lebih cepat daripada Hukum Moore, karena Anda bisa berinovasi di seluruh tumpukan.”

Pernyataan berani dari CEO Nvidia ini muncul pada saat banyak orang mempertanyakan apakah kemajuan AI telah terhenti. Laboratorium AI terkemuka — seperti Google, OpenAI, dan Anthropic — menggunakan chip AI Nvidia untuk melatih dan menjalankan model AI mereka, dan kemajuan pada chip ini kemungkinan akan diterjemahkan ke dalam kemajuan lebih lanjut dalam kemampuan model AI.

Ini bukan pertama kalinya Huang menyarankan bahwa Nvidia telah melampaui Hukum Moore. Pada sebuah podcast pada bulan November, Huang mengusulkan bahwa dunia AI sedang menuju ke arah “Hukum Moore yang lebih cepat.”

Huang menolak gagasan bahwa kemajuan AI sedang melambat. Sebaliknya, ia mengklaim bahwa sekarang ada tiga hukum penskalaan AI yang aktif: pre-training, fase pelatihan awal di mana model AI mempelajari pola dari sejumlah besar data; post-training, yang menyempurnakan jawaban model AI menggunakan metode seperti umpan balik manusia; dan test-time compute, yang terjadi selama fase inferensi dan memberi model AI lebih banyak waktu untuk “berpikir” setelah setiap pertanyaan.

“Hukum Moore sangat penting dalam sejarah komputasi karena itu menurunkan biaya komputasi,” kata Huang kepada TechCrunch. “Hal yang sama akan terjadi dengan inferensi, di mana kami meningkatkan kinerja, dan sebagai hasilnya, biaya inferensi akan lebih rendah.”

(Tentu saja, Nvidia telah berkembang menjadi perusahaan paling berharga di dunia dengan memanfaatkan ledakan AI, jadi pernyataan Huang ini menguntungkan bagi perusahaan.)

Chip H100 Nvidia adalah pilihan utama bagi perusahaan teknologi yang ingin melatih model AI, tetapi sekarang, dengan lebih banyak perusahaan teknologi yang fokus pada inferensi, beberapa pihak mempertanyakan apakah chip mahal Nvidia masih akan tetap unggul.

Model AI yang menggunakan test-time compute saat ini sangat mahal untuk dijalankan. Ada kekhawatiran bahwa model o3 OpenAI, yang menggunakan versi skala besar dari test-time compute, akan terlalu mahal bagi kebanyakan orang untuk digunakan. Misalnya, OpenAI menghabiskan hampir $20 per tugas menggunakan o3 untuk mencapai skor setara manusia pada tes kecerdasan umum. Sementara itu, langganan ChatGPT Plus dikenakan biaya $20 untuk penggunaan selama satu bulan penuh.

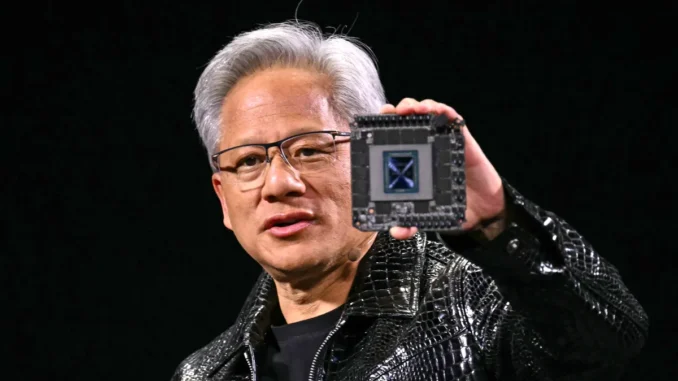

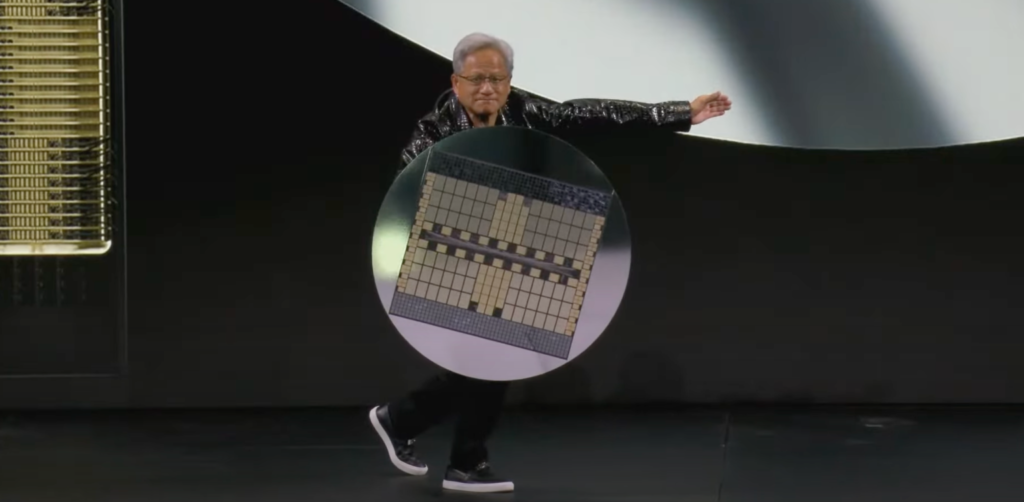

Huang memegang superchip pusat data terbaru Nvidia, GB200 NVL72, di atas panggung seperti perisai selama pidato utama pada hari Senin. Chip ini 30 hingga 40 kali lebih cepat dalam menjalankan beban kerja inferensi AI dibandingkan dengan chip Nvidia terlaris sebelumnya, H100. Huang mengatakan bahwa lonjakan kinerja ini berarti model pemikiran AI seperti o3 dari OpenAI, yang menggunakan banyak komputasi selama fase inferensi, akan menjadi lebih murah seiring waktu.

Huang mengatakan bahwa fokus utamanya adalah menciptakan chip dengan kinerja lebih baik, dan bahwa chip yang lebih berkinerja akan menciptakan harga yang lebih rendah dalam jangka panjang.

“Solusi langsung dan segera untuk test-time compute, baik dari segi kinerja maupun keterjangkauan biaya, adalah dengan meningkatkan kemampuan komputasi kami,” kata Huang kepada TechCrunch. Ia mencatat bahwa dalam jangka panjang, model pemikiran AI dapat digunakan untuk menghasilkan data yang lebih baik untuk pre-training dan post-training model AI.

Kami tentu telah melihat harga model AI jatuh drastis dalam setahun terakhir, sebagian berkat terobosan komputasi dari perusahaan perangkat keras seperti Nvidia. Huang mengatakan bahwa itu adalah tren yang ia harapkan terus berlanjut dengan model pemikiran AI, meskipun versi pertama yang telah kami lihat dari OpenAI cukup mahal.

Lebih luas lagi, Huang mengklaim bahwa chip AI miliknya saat ini 1.000 kali lebih baik dibandingkan dengan yang dibuatnya 10 tahun lalu. Itu adalah laju yang jauh lebih cepat dibandingkan dengan standar yang ditetapkan oleh Hukum Moore, yang menurut Huang tidak menunjukkan tanda-tanda akan berhenti dalam waktu dekat.

Leave a Reply